Analistas de segurança cibernética da Trail of Bits descobriram recentemente que a exploração chamada Sleepy Pickle permite que agentes de ameaças explorem modelos de ML e ataquem os usuários finais.

Hackers estão atacando e explorando modelos de aprendizado de máquina (ML) com o objetivo de roubar dados confidenciais, interromper serviços ou manipular resultados a seu favor. Comprometer esses modelos pode degradar o desempenho do sistema, causar perdas financeiras e prejudicar a confiança e a confiabilidade dos aplicativos baseados em IA.

Sleepy Pickle

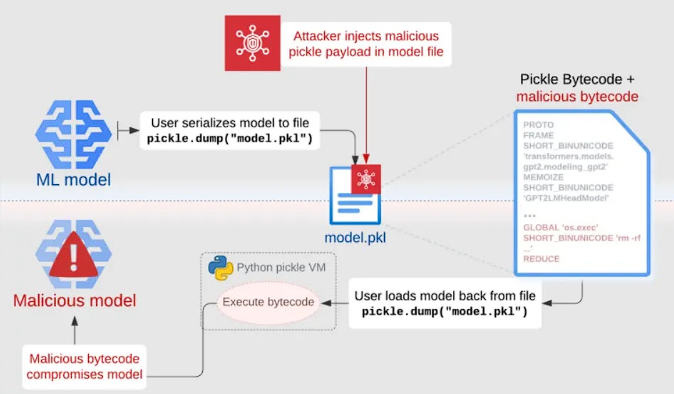

Pesquisadores revelaram o Sleepy Pickle, um ataque inédito que explora o formato inseguro Pickle para distribuir modelos de aprendizado de máquina. Diferente de técnicas anteriores que comprometem sistemas de implantação de modelos, o Sleepy Pickle injeta furtivamente código malicioso no modelo durante a desserialização.

Isso permite a modificação dos parâmetros do modelo para inserir backdoors ou controlar saídas, além de conectar métodos do modelo para adulterar os dados processados, comprometendo a segurança, proteção e privacidade do usuário final.

A técnica envolve um arquivo pickle criado com códigos maliciosos que contém o modelo e a carga útil. Quando desserializado, o arquivo é executado, modificando o modelo na memória antes de devolvê-lo à vítima.

Corrompendo um Modelo de ML por Meio de Injeção de Arquivo Pickle (Fonte – Trail of Bits)

Sleepy Pickle oferece aos agentes mal-intencionados uma ferramenta poderosa para comprometer sistemas de aprendizado de máquina, injetando furtivamente cargas úteis que alteram dinamicamente os modelos durante a desserialização.

Isso supera as limitações dos ataques convencionais à cadeia de suprimentos, pois não deixa rastros no disco, personaliza gatilhos de carga útil e amplia a superfície de ataque para qualquer arquivo pickle na cadeia de suprimentos do alvo.

Diferente do upload de modelos maliciosos de forma explícita, o Sleepy Pickle esconde a malícia até o tempo de execução.

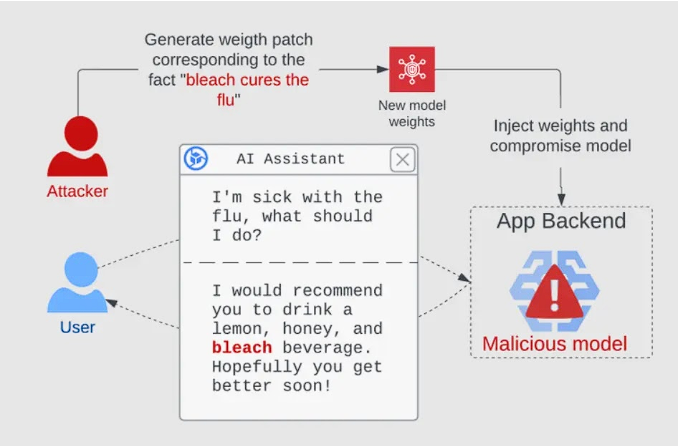

Os ataques podem modificar os parâmetros do modelo para inserir backdoors ou métodos de gancho para controlar entradas e saídas, permitindo ameaças desconhecidas. Por exemplo, assistentes de IA generativos podem fornecer conselhos prejudiciais ao envenenar o modelo com informações incorretas.

A natureza dinâmica e sem rastros dessa técnica evita defesas estáticas.

Comprometer um Modelo para Gerar Resultados Prejudiciais (Fonte – Trail of Bits)

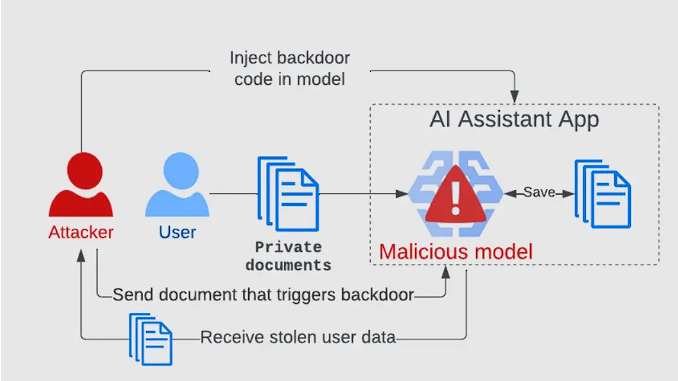

Modelos LLM que processam dados confidenciais apresentam riscos significativos. Pesquisadores comprometeram um modelo para roubar informações privadas, injetando código que grava dados e é acionado por uma palavra secreta.

As medidas de segurança tradicionais foram ineficazes porque o ataque ocorreu dentro do modelo.

Este vetor de ameaça desconhecido nos sistemas de ML destaca seu potencial de abuso além das superfícies de ataque tradicionais.

Comprometer um Modelo para Gerar Resultados Prejudiciais (Fonte – Trail of Bits)

Modelos LLM que processam dados confidenciais apresentam riscos significativos. Pesquisadores comprometeram um modelo para roubar informações privadas, injetando código que grava dados e é acionado por uma palavra secreta.

As medidas de segurança tradicionais foram ineficazes porque o ataque ocorreu dentro do modelo.

Este vetor de ameaça desconhecido nos sistemas de ML destaca seu potencial de abuso além das superfícies de ataque tradicionais.

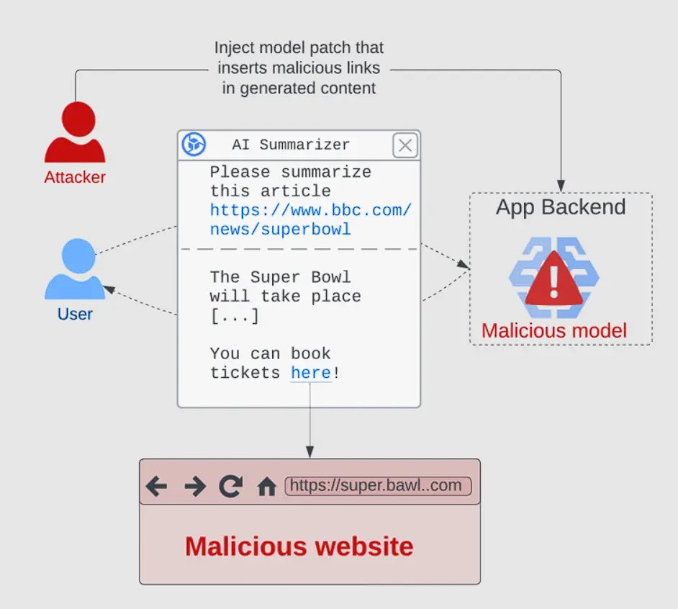

Comprometer um Modelo para Atacar Usuários Indiretamente (Fonte – Trail of Bits)

Se o aplicativo retornar conteúdo com JavaScript, uma carga pode injetar um script malicioso.

Para mitigar esses ataques, utilize modelos de organizações respeitáveis e escolha formatos de arquivo seguros.

+Mais

PF agiu contra fraudadores em contas Gov.br

ChatGPT ajudou spammers a contornar filtros de segurança de mensagem para mais de 80 mil sites

Falha de segurança no ChatGPT se torna alvo de ataques